Redash + Kettle解决方案

Redash自带简单的结果集再运算能力,提供从数据抽取、数据建模、数据分析,到数据可视化、预警分发的一站式数据分析应用能力; 即便试用专业的ETL工具,也可实现多数据源的联合动态分析(联动、钻取、动态参数等交互分析功能)。允许用户快速接入各类数据源,无需借助数仓即可实现数据导入-处理-分析的流程,因此Redash可以在没有数据仓库的前提下实现实时智能数据分析为主、辅以简单数据处理加工的应用场景。

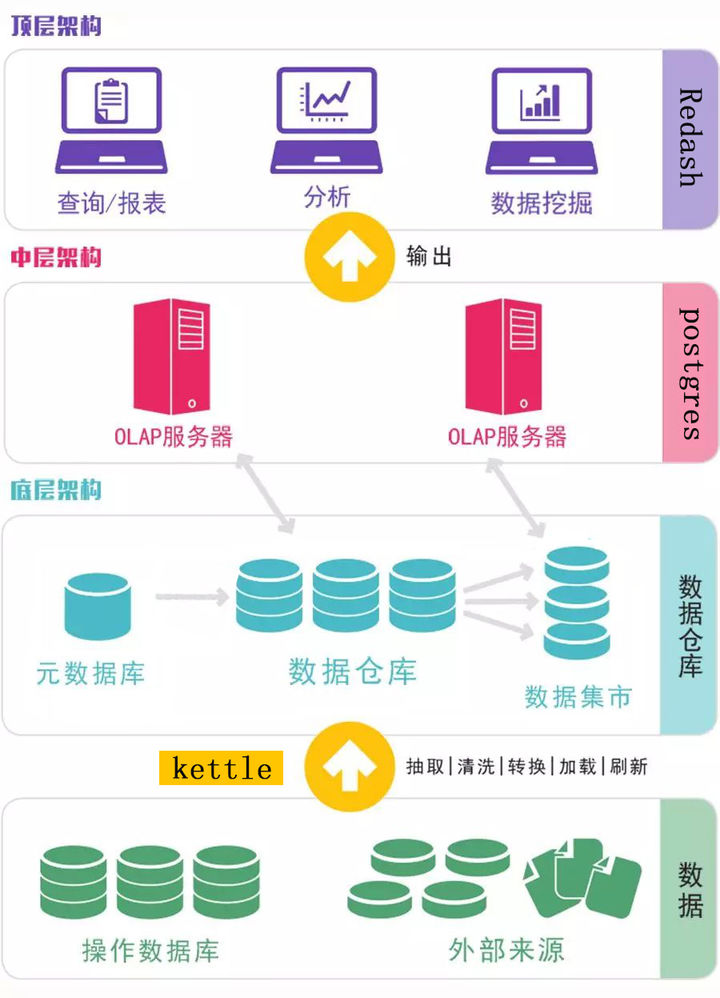

但是,随着企业用户数据量、分析复杂度的不断提升,数据分析平台上轻量式数据存储与数据流处理模块是难以承受巨大的计算压力的,需要大量指标运算、大量历史数据同比/环比运算的,还是需要有计划地建设数据仓库或数据平台。Redash能完美集成开源ETL工具Kettle,构建企业级数据仓库和BI系统。

数据不会像水一样从源头直接流进BI系统。通常我们需要ETL(即数据抽取、转换、装载的过程)工具来把数据从源头抓取到BI的数据仓库,ETL工具能将企业中的分散、零乱、标准不统一的数据整合到一起。

Kettle是一款高效易用的ETL工具,可以实现数据从多个异构数据源加载到目标地址。Kettle可以在Windows、Linux、Unix上运行,支持图形化的GUI设计界面,以工作流的形式流转,数据抽取、质量检测、数据清洗、数据转换、数据过滤等方面高效稳定。

Kettle介绍

Kettle是一个组件化的集成系统,包括如下几个主要部分:

1.Spoon:图形化界面工具(GUI方式),Spoon允许你通过图形界面来设计Job和 Transformation,可以保存为文件或者保存在数据库中。也可以直接在Spoon图形化界面中运行Job和Transformation,

2.Pan:Transformation执行器(命令行方式),Pan用于在终端执行Transformation,没有图形界面。

3.Kitchen:Job执行器(命令行方式),Kitchen用于在终端执行Job,没有图形界面。

4.Carte:嵌入式Web服务,用于远程执行Job或Transformation,Kettle通过Carte建立集群。

5.Encr:Kettle用于字符串加密的命令行工具,如:对在Job或Transformation中定义的数据库连接参数进行加密。

应用案例

某超市应用redash制作实时数据分析报表,前期主要获取最新实时数据,时效性要求高,因此采用redash直接动态获取数据库数据实时展示。

但是后期随着业务发展,数据取数越来越复杂,需要分析大量数据的指标和同比环比情况,而且数据即时性要求并不高时,采用redash多种结果集查询运算反复取数据,数据分析效率比较低。数据量非常大的情况,使用kettle可以直接作业和转换,一个作业里可以执行多个转换,这样数据分析效率就会大大提升,最后配合Redash进行可视化分析,制作报表进行展示。

Kettle可以简化数据仓库的创建,更新和维护,帮助企业快速搭建异构数据源之间的数据管道,让复杂的数据项目不再成为瓶颈,Redash+kettle=完整的BI项目解决方案,实现一站式打造企业级数据可视化分析云平台。